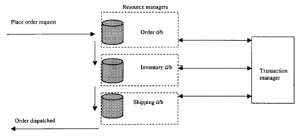

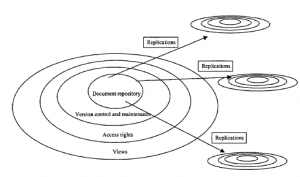

Przestrzegaliśmy przed zbyt nieformalnym podejściem do pracy zespołowej i podkreślaliśmy potrzebę formalnych, pisemnych zapisów. Pisemne dokumenty mają oczywiście starożytne pochodzenie; pierwsze charakteryzowały się tym, że miały jedno autorstwo, jedną datę wydania, jednego mistrza i rezydowały w jednej bibliotece. Rozwój prasy drukarskiej zniósł ograniczenie jednej kopii, ale tylko w miejscu pochodzenia. Wygodne, tanie kopiowanie w punkcie odbioru pojawiło się dopiero w latach 60., wraz z rozwojem procesu Xerox. Przez kilka lat dokumenty pozostawały ograniczone pod względem ich dostępności i ruchu. Były głównie prywatne, dla wybranych osób na określonych stronach. Dopiero niedawno wszystkie te ograniczenia zostały zniesione dzięki technologii, a organizacje wciąż pogodziły się z konsekwencjami. Najważniejszym z nich jest pojawienie się skoncentrowanego na dokumentach spojrzenia na procesy współpracy. W ten sposób dokumentacja nie jest już statycznym zapisem, umocowanym tylko w jednym określonym czasie lub miejscu, ale raczej ewoluującym, dynamicznym mechanizmem rozpowszechniania historycznej, aktualnej i powstającej wiedzy korporacyjnej w sposób terminowy i spójny w całej organizacji. Twierdzi się, że dzięki takiemu podejściu ludzie mogą w ramach jednej operacji złożyć wszystkie swoje raporty, arkusze kalkulacyjne, formularze, wiadomości e-mail itp. w miejscu, w którym mogą być nie tylko widoczne dla innych, ale także poprawione, opatrzone adnotacjami, uzupełnione lub włączone do innej dokumentacji. Możemy na przykład wyobrazić sobie, że informacje o produkcie są zestawiane i nad którymi pracujemy wspólnie, w dokumentacji projektowej, raportach sprzedaży, usterkach i reklamacjach klientów, tak aby uzyskać zintegrowany obraz całej sprzedaży, produkcji, dostaw i funkcji wsparcia w organizacji. Jak pokazano na rysunku, samo udostępnienie centralnego repozytorium całej dokumentacji korporacyjnej nie wystarczy.

Konieczne jest również wykonanie szeregu funkcji kontrolnych nad tym. Przede wszystkim musi istnieć jakiś mechanizm kontroli wersji, który pilnuje numeracji wersji, przydzielania dat i utrzymywania historycznych kopii zapasowych poprzednich wersji. Jest to kluczowy wymóg, jeśli dokumenty mają podlegać ciągłym zmianom, zwłaszcza jeśli zaangażowanych jest więcej niż jeden autor. To natychmiast zwraca uwagę na potrzebę kontroli dostępu i uprawnień. Kto będzie mógł zobaczyć dokument; kto będzie mógł go modyfikować? Co właściwie rozumiemy przez „kto”? Moglibyśmy mieć na myśli osobę z nazwiska lub osobę identyfikowaną tylko na podstawie roli, którą odgrywa, lub zespołu, do którego należy. W przypadku dostępu do Internetu coraz częściej musimy uwzględniać lokalizację użytkownika jako kwestię kontroli dostępu. (Czy ograniczamy dostęp do znanych adresów IP? Czy zapewniamy dostęp mobilny chroniony hasłem?) Musimy również zwrócić uwagę na to, co zobaczy użytkownik, gdy uzyska dostęp do repozytorium. Dokumenty będą istniały w wielu formach: arkusze kalkulacyjne, e-maile, diagramy, raporty itp., a niektóre będą istniały jako sekcje modułowe, które można zestawiać na wiele sposobów, tworząc przewodnik szkoleniowy, instrukcję obsługi lub naprawy, broszurę sprzedażową . Musimy zapewnić szereg widoków zawartości repozytorium, który odpowiada potrzebom użytkownika, a także umożliwia wyszukiwanie i przeglądanie. Na koniec musimy przyznać, że myślenie o istnieniu jednego, scentralizowanego, fizycznego repozytorium wszystkich danych w wielu organizacjach nie jest już rozsądne. Zamiast tego rozproszone satelitarne bazy danych i serwery proxy będą przechowywać lokalne replikacje części lub wszystkich danych. Będą musiały zostać zsynchronizowane. Produkty do pracy grupowej, które zapewniają solidne rozwiązania dla tych wymagań, są dostępne od jakiegoś czasu, przy czym dominującym przykładem są IBM (wcześniej Lotus) Notes. Notes obsługuje wszystkie opisane powyżej funkcje i zawiera system bezpieczeństwa oparty na szyfrowaniu kluczem publicznym w celu uwierzytelniania, kontroli dostępu i podpisów cyfrowych. W grę wchodzi uwierzytelnianie dwukierunkowe, w którym zarówno klienci, jak i serwery muszą potwierdzić swoją tożsamość przed rozpoczęciem dialogu. Dokumenty są jednoznacznie identyfikowane przez bazę danych, w której się znajdują, oraz numer w tej bazie danych. Są również opatrzone znacznikiem czasu z informacją o ostatnich zmianach. Istnieją złożone mechanizmy, które zapewniają synchronizację danych na wszystkich serwerach. Notatki zostały opracowane, zanim jeszcze zdano sobie sprawę z pełnego znaczenia Internetu, ale od tego czasu został rozszerzony wraz z rozwojem Domino, aby pasował do środowiska internetowego. Jednak nadal jest postrzegana przez niektórych miłośników Internetu jako podejście zorientowane na bazę danych, być może nawet przesadnie zaprojektowane. Jednym z problemów architektonicznych wynikających z modelu Internetu jest zakres, w jakim rzeczywiście wymagana jest replikacja danych. Skrajny pogląd jest taki, że wcale nie jest to konieczne: nie ma potrzeby śledzenia w oprogramowaniu do pracy grupowej kontroli wersji dokumentów; zamiast tego wszystko, co jest wymagane, to utrzymywanie listy adresów URL, pod którymi można znaleźć wersje. Nie wszystkie rozwiązania oprogramowania do pracy grupowej, które pojawiły się w ostatnich latach, wspierają ten mocny pogląd, ale mają zwykle lżejsze podejście do kontroli wersji niż te stosowane przez tradycjonalistów. Na koniec zwróć uwagę, że nie powiedzieliśmy nic o znajdowaniu odpowiednich informacji w tym potencjalnie ogromnym zbiorze danych korporacyjnych.