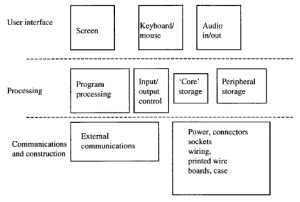

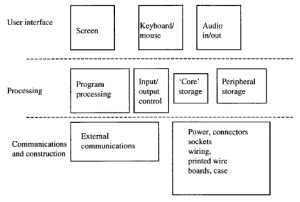

Jako maszyna, komputer nie jest szczególnie skomplikowany, w porównaniu na przykład z samochodem, a może nawet z telewizorem – nie jest to bynajmniej najmniejszy z powodów, dla których odniósł taki sukces. Aby to zrozumieć i spróbować przedstawić prawdopodobny postęp, ważne jest, aby przyjrzeć się temu szczegółowo. Na rysunku pokazujemy główne elementy komputera PC.

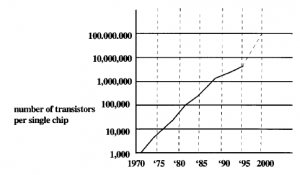

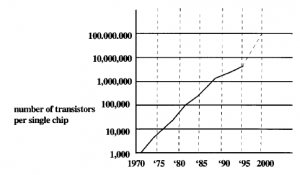

Trzy górne elementy na diagramie reprezentują typowe sposoby zapewniania interakcji między użytkownikiem a komputerem (i usługami za nim stojącymi). Ekrany mają zwykle przekątną około 15 cali, a najlepszą jakość obrazu nadal zapewnia czcigodny wyświetlacz z lampą katodową. Chociaż wyświetlacze ciekłokrystaliczne i inne wkraczają w tę dominację, jest mało prawdopodobne, aby utraciła swoją dominującą pozycję jeszcze przez kilka lat i możemy założyć, że jakość doświadczeń zakupowych będzie podobnie ograniczona w tym okresie. Klawiatura i mysz (lub kulka śledząca) są dominującymi mediami wejściowymi i prawdopodobnie nie jest zbyt ryzykowne stwierdzenie, że one również pozostaną takimi przez podobny okres. Istnieje pewne zainteresowanie wejściem-wyjściem głosowym w aplikacjach mobilnych, ale nadal nie jest to zbyt niezawodne, a w każdym razie może być denerwujące dla innych osób w pobliżu. W związku z tym jest mało prawdopodobne, aby nastąpiła jakakolwiek radykalna zmiana ich funkcji wejścia / wyjścia pokazane na następnym poziomie niżej. Jednak w przypadku możliwości przetwarzania programu przez komputer, jego „inteligencji” jest zupełnie odwrotnie. Sercem (a może i mózgiem) każdego komputera jest chip procesora, układ scalony składający się z około miliona aktywnych elementów elektronicznych. Moc obliczeniowa komputera jest w przybliżeniu związana z liczbą tych aktywnych obwodów pomnożoną przez ich szybkość działania. Zadziwiające jest to, że w ciągu ostatnich trzech dekad wzrosła liczba takich komponentów dostępnych w jednym układzie scalonym; to, co zapiera dech w piersiach, to dalszy potencjał. Wykres pokazany na rysunku 3.8 pokazuje niezwykłe zjawisko znane jako „prawo Moore’a” (od Geralda Moore’a, jednego z założycieli Intela), że liczba tranzystorów na chip (lub równoważnie koszt na jednostkę mocy obliczeniowej) jest większy. niż podwaja się co dwa lata.

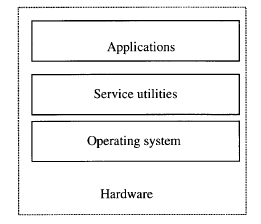

Co więcej, wielu ekspertów uważa, że trend ten utrzyma się jeszcze przez co najmniej jedną dekadę. Jeśli ta prognoza jest słuszna, komputery w roku 2010 będą około tysiąc razy wydajniejsze niż dzisiaj. Akceptując przepowiednię, możemy rozglądać się za czymś, do czego można wykorzystać tę ogromną moc. Od razu przychodzi na myśl jedna aplikacja – lepsza jakość grafiki. Chociaż nadal ograniczamy się do podstawowych wyświetlaczy wizualnych, możemy sobie wyobrazić, że są one napędzane przez bardziej wydajne oprogramowanie, które umożliwia tworzenie interfejsów rzeczywistości wirtualnej o niezwykle wysokiej jakości, a tym samym wysoce uwodzicielskich do gier komputerowych lub do tworzenia sklepów internetowych . Ten trend w mocy obliczeniowej, jak pokazano na rysunku rozciąga się również na „pamięć rdzenia”. Termin pierwotnie odnosił się do mechanizmu konstrukcji tej pamięci (dosłownie, maleńkich toroidów z materiału magnetycznego). Obecnie częściej używanym terminem jest „pamięć o dostępie swobodnym” lub pamięć RAM, ale woleliśmy użyć wcześniejszego terminu: przypomina nam, że rdzeń pamięci jest „rdzeniem” elementów przetwarzających komputera w porównaniu z dyskami twardymi i tym podobnymi, które są urządzeniami peryferyjnymi. Rdzeń jest wymagany, gdy oprogramowanie ma być uruchamiane szybko; wykonywany program musi znajdować się w rdzeniu, a nie na urządzeniu peryferyjnym, ponieważ dostęp do tego ostatniego jest znacznie wolniejszy. Na przykład w przypadku systemów operacyjnych niektóre czynności jądra, takie jak kontrola podstawowych danych wejściowych i wyjściowych, zawsze pozostają w rdzeniu, podczas gdy mniej krytyczne czasowo lub rzadziej używane narzędzia są przechowywane na dyskach i ładowane do rdzenia tylko wtedy, gdy jest to wymagane .

Core jest również używany, gdy chcemy przeprowadzić implementacje programowe kodowania i dekodowania wideo i audio. Schematy kodowania, takie jak standardy wideo MPEG, które muszą przechowywać kolejne klatki strumienia wideo, aby mogły przesyłać tylko zmiany, wymagają pamięci o szybkim dostępie. Często wygodnie jest odtworzyć układ ekranu za pomocą zestawu lokalizacji pamięci „planu wideo”, które mogą pomieścić wszystkie dane dla pojedynczej klatki wideo, a także inną płaszczyznę dla tekstu i grafiki, które zostaną nałożone na podstawowy obraz. Wszystkie te wymagania – zwiększona moc obliczeniowa, wyświetlanie wideo i kodowanie – stanowią powód do ostrożności w przypadku twierdzeń, że PClite/komputer sieciowy może być uproszczoną wersją dzisiejszego komputera. Jest całkiem prawdopodobne, że to, co obserwujemy, jest raczej spowolnieniem niż odwróceniem specyfikacji procesora i pamięci rdzeniowej. Projektanci prawdopodobnie nie powinni myśleć w kategoriach prób projektowania według bardzo ograniczonej specyfikacji sprzętowej. Na przykład rozwój prototypów dekoderów telewizyjnych (które są prawie we wszystkim, komputerami osobistymi) ujawnił, że ograniczenie się do małego rozmiaru jest złą rzeczą. Jeśli pamięć rdzeniowa i szybkość przetwarzania podlegają dramatycznej poprawie, niewiele można powiedzieć o pamięciach peryferyjnych i innych urządzeniach. Pojemność pamięci peryferyjnej i szybkości dostępu rosły w coraz bardziej stabilnym tempie, zasadniczo liniowym z upływem czasu. Idąc w czasie z nimi, wymagano pamięci masowej dla kompletnych systemów operacyjnych i narzędzi. Tutaj znowu mamy problem z komputerem sieciowym. Czy zamierzamy oszczędzić na kosztach sprzętu i problemach z konserwacją, usuwając dysk twardy i zamiast tego ładować części systemu operacyjnego, gdy jest to wymagane, z centralnego serwera? Jeśli tak, to albo zamierzamy mieć dość ograniczony system operacyjny, narzędzia i aplikacje lub bardzo szybki kanał, z którego można je załadować, jeśli mamy zapewnić odpowiednią usługę. Do niedawna ten wymóg sieciowy mógł być największą przeszkodą na ścieżce krajowego rynku komputerów sieciowych. Gdzie mieliśmy uzyskać wystarczająco szybkie możliwości pobierania? W środowiskach biznesowych i, być może, edukacyjnych, serwer zawierający fragmenty programu może współdzielić sieć lokalną z komputerem klienckim i mieć możliwość, za pośrednictwem tej sieci, dostarczania danych z szybkością znacznie przekraczającą 1 MB. Ale co z użytkownikiem domowym, który utknął na drugim końcu linii telefonicznej oferującej szybkość transmisji danych w analogowej sieci telefonicznej poniżej 8 kb/s lub w droższej cyfrowej sieci ISDN, która jest tylko cztery lub pięć razy większa? Jednak, jak wyjaśniono w tym rozdziale, ostatnie osiągnięcia w zakresie modemów kablowych i cyfrowej pętli abonenckiej mogły wzmocnić sytuację w sieciowym komputerze PC, obiecując przynajmniej szybkość przesyłania danych zbliżoną do 250 kb/s. Debata o sieciowym komputerze PC jest ponownie żywa i może znacząco wpłynąć na ewolucję platformy zakupów domowych.